介绍常用的文本分类模型与技术,特别分析基于统计和基于语义两种文本倾向性分析的方法,尝试将两者结合起来,提出基于模式抽取和匹配基础上的文本倾向性分类算法,并进行测评,然后介绍基于网络信息文本倾向性分析的技术实现,同时结合领域应用进行简单的实证分析。

This paper firstly introduces the model and technology of text classification, especially analyzes and compares two methods of text semantic orientation based on both statistical and semantic analysis. Then it proposes pattern matching based on the extraction and text classification algorithm, and evaluate this algorithm. Finally, the authors describe the technical implementation and fields application of text semantic orientation.

文本倾向性分析(Text Semantic Orientation)是目前文本挖掘领域的研究热点,涉及到自然语言处理、信息检索、数据挖掘等领域。文本倾向性分析也是一种特殊的文本分类。文本分类指的是按照一定的规则来确定一篇文本的分类,而文本倾向性分析与传统的基于主题的文本分类有所不同,其主要用来判别一段文本中表达的观点、对一件事物的好恶及态度倾向等信息。本文所研究的文本倾向性分析是指给定一段文本,由机器来自动判断该文本所表达内容带有的情感倾向性,有时这类问题又被称作情感分类(Sentiment Classification)[ 1]、观点鉴别(Opinion Classification)[ 2]、褒贬分类[ 3]等。

近几年,有关自然语言处理、计算语言学、数据挖掘以及Web应用等领域的多个国际顶级会议(AAAI、ACL、COLING等)都收录了文本倾向性分析的相关论文。其中AAAI 2004春季研讨会的主题就是探索文本中的态度与情感;AAAI 2006春季研讨会则关注利用自动计算的途径对Weblog(Blog)进行分析,其中也包含了大量文本倾向性分析方面的论文。国内的计算语言学会议也纷纷将文本倾向性列为会议的主题。2005年在南京召开的第八届计算语言学联合学术会议上,邹嘉彦[ 4]做了“评述新闻报道或文章色彩——正负两极性自动分类研究”的报告;2007年在苏州举办的第三届全国信息检索与内容安全学术会议也设立了倾向性分析主题[ 5];2008年8月到10月间中文信息学会信息检索专委会主办了第一届中文倾向性分析测评(COAE2008)[ 6],设置了5个一般性任务和1个探索性任务,包括了侧重于词语级的中文情感词的识别和分析,侧重于要素级的倾向性相关信息抽取(主要是抽取句子中的评价对象),侧重于篇章级的中文文本倾向性的判别。2009年在上海交通大学举办的第五届全国信息检索学术会议(CCIR)专门安排了文本倾向性分析的主题演讲[ 7]及相关讨论,同时进行了第二届中文倾向性分析评测。随着更多研究者进入文本倾向性分析方面的研究,各类的探讨也越来越多,在包括主观性判别、词语的语义倾向性识别、观点提取、文本的整体极性分类等诸多方面取得了一定进展。

随着文本倾向性分析技术被广泛关注和研究,基于情感的文本分类已在多个领域中有了实际应用,尤其在一些商业智能系统中。Microsoft公司开发的智能系统Pulse[ 8]可以从大量用户评论数据中利用文本挖掘技术提取出用户对产品具体功能的看法;Morinaga等[ 9]开发了一种对商品进行声誉分析的系统RSE,通过对搜索到的相关评论进行倾向性分析并以图形的方式显示出用户的偏好;Tong[ 10]提出了一种基于时间的情感倾向检测跟踪系统,该系统跟踪关注影评,显示网民的情感倾向随着时间变化的曲线图;Liu等[ 11]开发的产品反馈系统Opinion Observer,对互联网上丰富的顾客评论的主观内容进行分析,提取产品各个特征及消费者对其的评价;姚天昉等[ 12]研究并开发了一种用于汉语汽车论坛评论挖掘系统,在专业的汽车论坛上挖掘评论者对各种品牌汽车的性能指标的意见和评价,判断这些意见的极性以及强弱程度,并且以可视化的方式给出结果。

进行文本的倾向性分析是一个相对比较复杂的过程,通常包含三个子问题:文本的主客观分类,即区分出文本内容是主观的评论还是客观的陈述;文本的极性分类(Polarity Classification),又称为正负面倾向分类,即判断文本内容是正面的肯定赞赏还是负面的否定批判;判定文本情感倾向性的强弱程度,比如说是强烈反对、一般反对、中立、一般赞扬、强烈赞扬等,这一问题有时又被称为等级推理(Rating Inference)。本文主要关注前两个方面,即文本的主客观分类和极性分类问题。

本文提出了一种基于词性的N-Gram模型用以抽取文本中的主观部分,进而计算文本的极性及强度,该分类方法在保持较高性能的同时获得了一个比较理想的准确率;还构建了实验中所用极性词典,含有正面情感词条4 560条,负面词条4 369条,该词典可以为今后文本倾向性分析的研究提供重要资源;在此基础上还开发了文本倾向性分析工具,用于网络商品评论信息的文本分析。

一个典型的文本分类处理流程如图1所示:

(1) 文本表示模型与文本特征提取

计算机系统尚不能够直接理解自然语言文本所表达的含义,因此对文本进行分类之前需要将文本表示为计算机能够处理的形式,建立文本的表示模型。其中最常用的文本表示模型是Salton等[ 13]于1975年提出的向量空间模型(VSM),因较好的实用效果而被广泛应用于数据挖掘、信息检索等领域研究中。不过,用文本表示模型生成的特征中可能存在很多噪声,一般需要特征压缩对一些不太重要的特征予以去除,从而起到降低向量空间维数的作用。

文本特征压缩的研究大体可以分为特征选择和特征加权两方面,两者不是相互独立的,不同的特征加权模式对应着不同的特征选择方式,实际应用中可以将文本特征选择和文本特征加权归结为文本特征抽取一并处理。目前常用的文本特征选择方法有互信息法(Mutual Information,MI)、信息增益(Information Gain,IG)、统计(CHI)等方法[ 14, 15],常用的文本特征加权计算模式有布尔函数、词频函数、信息熵权重、TF-IDF(Term Frequency- Inverse Document Frequency)函数等。

(2) 基于统计的文本分类模型

文本在被表示为计算机可读取的文本特征向量形式后,可以使用多种分类器算法在文本样本集合上构建分类器,完成文本分类任务。大量的分类算法建立在统计学的基础上,通过比较文本特征向量与预定义类别的特征向量之间的相似度来进行归类。常用的算法模型包括朴素贝叶斯(Naive Bayes,NB)模型[ 16, 17, 18]、最大熵(Maximum Entropy)模型[ 19, 20]、支持向量机(Support Vector Machine,SVM)模型[ 21, 22]等。相关讨论较多,本文不再赘述。

(3) 语义倾向的分析方法

语义倾向分析是一种结合词语语义与统计方法分析文本类别的方法,这一方法在英文领域得到了广泛的研究及应用,但中文跟英文有较大的差异。在对文本进行倾向性分析时,对中文文本的处理有其特殊的地方,中文文本是按句子进行分割的,词语之间无间隙,因而在中文文本处理中词的切分与英文大为不同。

在应用语义倾向性方法时经常涉及语义相似度和语义相关度两个概念。语义相似度是指两个词语在不同的上下文中可以互相替换使用而不改变文本含义的句法语义结构的程度,相当于是同义词的概念。而语义相关度包含了语义相似度的概念,指的是在句法分析中一个短语结构中的两个词能够组成修饰关系、主谓关系、同指关系的程度,是一种搭配修饰的概念。语义相似度有两类常见的计算方法,根据本体(Ontology)或分类体系(Taxonomy)来进行计算,利用大规模语料库进行统计。第一种方法通常从义项入手计算语义相似度,第二种方法则是在语料中计算每个词的特征词向量,然后利用这些向量之间的相似度(用向量的夹角余弦计算)作为这两个词的相似度。本文的语义相关度则根据词语在句法树中的位置来计算。

本文通过现有语言资源构建了对文本倾向性分析的中文极性词典,然后从词性出发提出了一种基于词性的N-Gram模型,用以提取文本中的主观信息,然后对文本倾向性极性和强度进行判定,这是一种语义与统计相结合的文本倾向性分析方法。同时通过中文情感挖掘语料ChnSentiCorp对以上提出的模型及极性判定方法进行测评,测评结果较为理想。

词语除了表达所特有的概念以外,还能传达特定的感情色彩。所谓感情色彩义,指的就是该词语所体现出来的反映说话人对所指对象或有关现象的主观态度及各种感情。感情色彩义大体分为褒义和贬义两种,凡是表示对有关事物或现象的喜爱、赞扬、尊重等感情态度的词义就是褒义,如“卓越”、“聪明”、“优秀”等;凡是表示说话人对有关对象的厌恶、轻蔑、讽刺等感情态度的就是贬义,如“拙劣”、“鄙夷”、“顽固”等。词汇的褒贬义是一个词语词义的重要组成部分,然而明确标注词语情感义的常用词汇语言资源还比较少,但这是文本倾向性分析的重要基础,所以极性词典的构造工作也就成为后续研究工作开展的前提和基础。

与英文文本倾向性分析研究中公认的最常用的基础资源即哈佛大学于1966年整理开发的General Inquirer(GI)[ 23]词典不同,现在中文环境中还没有一部可直接服务于文本倾向性分析的较为完备和通用的词典资源,这就需要综合已有的语言资源构建自己的极性词典,本文构建情感极性词典用到的中文资源包括:

(1)《知网》(HowNet)资源[ 24],目前公布的情感词汇资源信息包括程度级别词语219个、负面评价词语3 116个、负面情感词语1 254个、正面评价词语3 730个、正面情感词语836个、主张词语38个,本文使用《知网》2000 版作为极性词典构建的基础;

(2)张伟等[ 25]编纂的《学生褒贬义词典》,该词典共收录了含有褒义或贬义的双音词、成语和惯用语共1 669条,其中褒义词730条,贬义词939条,其优点在于为所有的词语明确标注了其情感倾向,并且为每个词语列出了与其褒贬色彩相同的近义词语,同一个词语在不同词性时所代表的情感倾向也有明确的标记;

(3)史继林等[ 26]编著的《褒义词词典》,共收录了5 067个词条;

(4)杨玲等[ 27]编著的《贬义词词典》,共收录了3 495个词条;

(5)哈尔滨工业大学信息检索研究室发布的《同义词词林》扩展版[ 28, 29],收录的词语共有 77 343 条,因同义词之间往往有相同的极性,故对于极性词典未曾收录的词语,可通过参考其同义词判断极性。

本文构建的极性词典结构如图2所示。

它主要由4个部分组成:

(1)基本极性词典

词典的基本组成部分,用于判定一些常见词语的极性,这些词语不具有动态极性,即在不同的文章中,这些词语的极性基本保持不变。基本极性词典包括 HowNet 情感分析用词语集中的 “正面/负面评价”词语以及“正面/负面情感”词语,这些词语是从大量语料中总结出来最常用的极性词语,基本囊括了中文中正负面感情色彩的词语。

(2)领域极性词典

通过对领域应用的研究,针对某个具体领域应用时需要一个特定的领域极性词典以获得较好的性能。在针对领域搜集极性词的过程中发现,某些极性词在修饰一些具体特征时会发生变化,比如“它不愧是有史以来最轻薄的手机!”,“轻薄”一词在基本极性词典中被定义为贬义,经常是用来修饰人的,但是这句话中的修饰对象是手机,显然具有褒义,这说明词语褒贬有时会根据词语所修饰的对象发生改变。所以针对领域内的一些特殊褒贬词语的收集整理可以大幅提高极性判断的准确性,也可以利用领域词典为那些具有不同极性的词语找到合适的极性,即若一个词语在领域极性词典及基本极性词典或是其他词典中同时出现,以领域极性词典中的极性为准。

(3)网络极性词典

网络极性词典搜集了常用的具有极性的在BBS、微博、新闻评论、SNS社区经常出现的网络词语。因为文本倾向性分析被大量用于网络信息文本处理中,所以有必要收集整理一些网络常用词语,并从中挑选出具有褒贬义的词语,构成了网络极性词典,如“顶”、“弓虽”、“稀饭”等。

(4)未登录词语计算词典

未登录词语指的是经过分词、搭配选择以后的词语未在以上三种词典中匹配到,于是会在未登录词语计算词典中寻找匹配,计算资源主要由《同义词词林》及扩展词语集所构成。前者是通过计算同义词的极性来获得未登录词语的极性,后者是指人工添加的没有登录的极性词语,有些词语可能在以上这些词典中都无法匹配,于是需要手工添加一些新词使得极性词典获得比较好的性能,这些词语的极性通过查《褒义词词典》和《贬义词词典》获得。

极性词典的查找先后顺序是领域极性词典、基本极性词典、网络极性词典和未登录词语计算词典。本文所使用的极性词典包含正面情感词条4 560条、负面情感词条4 369条,现阶段还在不断更新和丰富中。

在传统的文本分类中,寻找到文本中的主题词很重要,而在文本倾向性分析中具有主观性的词语及搭配更重要。在现有的基于语义的方法中,主观性模式的自动识别与判断是一项基础性技术,因为一段文本的情感倾向主要是通过主观性语句来表达的。同时,在文本中出现的每个词语都会有一个词性,因此可以从词语的词性入手,通过词语的词性的搭配来识别并提取其中的主观性部分。

在传统的文本分类中,最常用的文本表示模型是向量空间模型,但是这一模型在语义应用方面效果并不明显,因此本文从词性出发,结合文本的统计和结构方面的内在规律,构建了一种基于词性的N-Gram模型。其主要思想是将文本中的词语按照其语法功能进行词性标注,再用文本中连续出现的N个词性的顺序进行组合成为一个项,以此来对文本进行表示。具体而言,首先把文本信息中的复合语句,也就是含有多个主谓关系的句子,进行分割,然后进行分词和词性标注,接着对分词标注好的词语信息进行匹配,当N=1时,指的是单一词语的词性匹配,意义不大;当N=2时,是一种较为简单实用的模型,例如:

我非常喜欢看这本书。

分词并词性标注后的结果为“我(代词)非常(副词)喜欢(动词)看(动词)这(代词)本(量词)书(名词)。(标点符号)”,则该语句的2-Gram模型是“代词-副词,副词-动词,动词-动词,动词-代词,代词-量词,量词-名词”,其中“代词-副词”即为一个2-Gram项,反映主观情感倾向的2-Gram项被称为2-Gram主观模式,比如该例子中的非常(副词)喜欢(动词)这一“副词-动词”模式。

本文通过实验的方法获取和总结文本倾向性的N-Gram主观模式,具体算法由以下几个步骤组成:

(1)通过采集工具获取大量包含主观句和客观句的文本语料(主要是网络信息);

(2)采用人工标注试验的方法筛选和标定其中主观性与客观性相对明确的句子;

(3)使用中文自动分词与词性标注工具进行分词和词性标注(使用ICTCLAS);

(4)对每一个主观句子提取全部连续的N-Gram模式;

(5)从中再提取能有效表达文本情感倾向性的N-Gram主观模式。

在大量文本实验基础上,总结出效果较好的几种N-Gram,主观提取模式如表1所示:

| 表1 N-Gram主观提取模式 |

文本倾向性判断首先是基于文本主观性识别模式和极性词典加以确定,而对于那些不具有清晰的语法结构的网络评论文本可能无法与上述模式匹配,这时可以采用统计的方法进行计算,即分词及词性标注后对所有词语的极性值求和。

有了基于词语和其搭配模式的极性判别方法后,需要进一步做的是对极性强度进行计算,其主要思想是根据不同的程度修饰词来判断词语极性的强度,方法是对这些修饰词设置不同的系数,需要确定的是修饰词不能改变被修饰词的极性,最多只能改变强度大小。词语极性分为三类:褒义(Positive)、贬义(Negative)、中性(Mid),原始极性强度分别设置为+2、-2、0。词语的极性强度会随着不同程度的级别修饰词语而扩大或减小,程度级别词语分为以下几类,包括“极其/最”这一程度级别的词语集为L1,修饰系数为3;包括“非常/很”这一程度级别的词语集为L2,修饰系数为2;包括“比较”这一程度级别的词语集为L3,修饰系数为1.2;包括“稍微”这一程度级别的词语集为L4,系修饰数为0.8。

整个文本的极性强度是通过计算整篇文本中所有观点词的极性强度获得的。对一篇文本可以从N-Gram主观提取模式提取出主观性语句的文本,对这些主观性语句的极性值求和便作为该文本的极性值;而对于那些不具有清晰的语法结构、未能通过N-Gram主观提取模式提取出主观性语句的文本则对所有的词语的极性值求和作为该文本的极性值。具体的算法由以下几个步骤组成:

(1)对文本进行N-Gram主观提取模式提取;

(2)对能够进行N-Gram主观提取模式匹配的文本中的匹配词语进行筛选,选取除了名词以外的词语进入步骤(3),对于那些不具有清晰的语法结构未能通过N-Gram主观提取模式提取出主观性语句的则选取所有词语进入步骤(3);

(3)通过领域极性词典判断极性,在领域极性词典中查找该词语,如果匹配则确定极性,然后执行步骤(6),不匹配则执行步骤(4);

(4)在基本极性词典中查找该词语,如果匹配则确定极性,然后执行步骤(6);如果不匹配则在扩展极性词典中继续查找该词语,如果匹配则确定极性,然后执行步骤(6),不匹配则执行步骤(5);

(5)对未登录词语的极性进行判断,首先在扩展词语词典中寻找,如果匹配则确定极性,然后执行步骤(6),否则对该词语进行同义词扩展,使用《同义词词林》的扩展计算其极性公式,然后执行步骤(6);

(6)计算词语极性强度,根据已确定的极性和修饰程度进行计算;

(7)检查该词语是否被否定修饰,若被否定关系所修饰,对取值进行反操作,否则不改变;

(8)对可以从N-Gram主观识别模式提取出主观性语句的文本计算这些主观性语句的极性值并求和作为该文本极性值,而对那些不具有清晰语法结构未能通过N-Gram主观提取模式提取出主观性语句的文本则对所有的词语的极性值求和作为该文本的极性值。

文本倾向性分析中用到的评价方法一般沿用了文本主题分类的评价指标,包括准确率(Precision)、召回率(Recall)和 F-measure[ 30]。本文对F-measure计算公式中的准确率和召回率平等对待,此时 F-measure 又被称为 F1 值。

中文情感挖掘语料ChnSentiCorp[ 31]是由中国科学院计算技术研究所收集整理供自然语言处理学习研究人员使用的一个公开语料库,语料库主要包括三个领域:酒店、电脑(笔记本)与书籍,该语料库为平衡语料库,其中包含正负类文本各2 000篇,褒义文本和贬义文本都已经人工标注好,直接进行测试即可。测评结果如表2所示:

| 表2 基于ChnSentiCorp的文本倾向性分析测评 |

测评结果显示该算法贬义文本的准确率略高于褒义文本的准确率,褒义文本的召回率略高于贬义文本,平均下来有着可以接受的78%的准确率和64%的召回率,F1值均在0.7左右,可达到文本倾向性应用领域的一般需求。随着极性词典的进一步完善和主观提取模式的进一步提炼,其结果会越来越好。同时,该倾向性分类算法比较简洁,不涉及复杂性较高的计算,实现性能较好,后面会将其用于海量网络信息文本的倾向性分析上。

随着计算机和互联网技术的迅猛发展,网络已经成为一个巨大的信息源,而Web2.0之后,网民也越来越习惯将网络作为自己表达观点、想法、态度的平台,而不只是被动地接受网站所发布的信息,大量的具有个人观点性的内容充斥着网络,过去人们主要着眼于这些文本信息中客观部分的处理,而现在挖掘和分析网络信息文本中的观点、立场、态度、看法、感觉、情绪、好恶等主观信息越发地重要和迫切,在商品评论、网络舆情、网络口碑等诸多应用领域有着广泛的需求。

在进行网络信息文本倾向性分析研究之前需要进行大量的基础性工作,包括数据的采集(如商品评论信息)、正文信息的提取、分词及标注等,其后才能选择不同方法或者策略进行文本倾向性分析,其间涉及大量的方案设计和技术实现。

对于特定主题的领域信息的采集,主要采用网络爬虫采集技术。网络爬虫通过指定的入口,按照一定的规则以网络链接的拓扑结构漫游于所需要遍历到的所有网络节点,它在Web上按某种策略进行远程数据搜索并下载,然后建立本地索引,产生一个本地数据库,将所需结果反馈给用户。网络爬虫通常以用户指定的一个或多个种子URL作为工作的起点,通过各类端口发送遵循HTTP协议格式的指令(通常使用GET方法),远程服务器根据申请指令的内容返回相应格式的文档(通常是一个HTML文档)。网络爬虫的采集模块收集返回文档中所有的信息,然后保存至缓存(Cache),经过固定的时间后将搜索到的文档传送到数据库中保存。同时,对已提取文档中新出现的超链接进行访问,并剔除掉已经访问过的超链接,如此循环反复,按照一定的搜索策略对互联网中的Web文档信息进行搜索[ 32]。爬虫技术广泛应用于各类信息处理分析系统中,对于所需要的特定领域的网络信息文本,本文采用了自主开发的网络爬虫加以搜集。

互联网上大多数的Web网页文档内容中都充斥着各种冗余信息和不相关垃圾信息,如广告、导航信息、版权信息等。这些内容与本文的研究不相关,不但增加了网页信息的存储开销,还对文本处理、语义分析处理带来非常大的噪音,会减弱处理效果,因此需要进行信息抽取,方便文本后续的保存、处理和分析。网页信息抽取方法主要是针对HTML语言的一些特点进行处理,只需提取特定HTML标记之间的文本即可。

中文分词研究已较为成熟,根据是否使用切分词典,可分为有词典切分和无词典切分。根据切分的具体方法,可分为基于规则的方法和基于统计的方法。本文采用中国科学院计算技术研究所研制的汉语词法分析系统ICTCLAS(Institute of Computing Technology, Chinese Lexical Analysis System)[ 33],它采用了层叠隐马尔可夫模型(Hierarchical Hidden Markov Model),主要功能包括中文分词、词性标注、命名实体识别、新词识别;同时支持用户词典,其分词速度单机可达996KB/s,分词精度达到98.45%,分词效果良好。本文采用ICTCLAS 2011版进行文本的分词及词性标注。

文本倾向性分析处理的第一步是导入构建的极性词典,本文将每一个词典单独保存为一个文件,在需要时进行调用,这样不但方便对字典的修改,而且不需要修改程序。在程序中,这些字典都是键值对应的类型,使用HashTable类型进行存储,这样可以保证较高的效率,而且在查找时比较方便,主要实现代码(C#)如下:

//导入字典,返回Hashtable类型的Dict

private Hashtable loadDict()

{

const string DICT_POS = @"POS.DAT"; //正面情感词语字典

const string DICT_NEG = @"NEG.DAT";//负面情感词语字典

const string DICT_DOMAIN = @"DOMAIN.DAT";//领域极性字典

const string DICT_USER = @"userDict.DAT";//扩展词语字典

Hashtable Dict = new Hashtable();

string lineStr = null;

//导入正面情感词语

if (File.Exists(DICT_POS))

{

StreamReader sr = File.OpenText(DICT_POS);

try{

while ((lineStr = sr.ReadLine()) != null)

{

string[] str = lineStr.Split(′,′);

if (!Dict.Contains(str[0]))

{

Dict.Add(str[0].Trim(), str[1].Trim());

}

catch (Exception ex)

{

MessageBox.Show(ex.ToString());

}

......

return Dict;

}

程序使用Microsoft VS 2008开发,可以实现对文本、TXT、EXCEL及MySQL数据库中的文本进行倾向性的判断。界面如图3所示:

电子商务迅猛发展,互联网商家为了对网上购物的消费者提供更好的参考服务,基本上所有的购物网站都在每个商品的下方为消费者提供发表评论的位置,这样可以及时地将客户对商品的评论反馈给商家及潜在消费者。商家可以了解用户对产品的评价及发现产品的不足,同时可以了解用户的潜在需求,从而对产品进行改进;消费者可以通过已购买者了解商品的真实体验及各方面性能,从而理性地选择产品[ 34]。面对数量众多的评论,迅速地获取其中所包含的评价信息,无论是商家还是消费者都有着浓厚的兴趣,可见文本倾向性分析在商品评论挖掘中有广泛的应用价值。

研究的目的在于应用实践,笔者希望将开发的工具应用到具体领域,在实际应用过程中对极性词典、标注工具等进行完善和修正,也能尝试进行一些领域信息分析。限于篇幅,本文仅选取国内B2C门户之一的当当网的商品评论来进行简单的实例分析,选择其图书畅销榜[ 35]中的图书作为研究对象,对排名前20的图书的评论进行采集,总计27 401条,如表3所示:

| 表3 当当图书畅销榜前20书籍名称及评论数 |

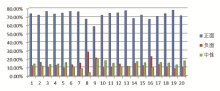

利用开发的工具对其进行文本倾向性分析处理,结果如图4所示。

(1)在图书评论中偏向于正面的较多。通过对实验中20本书的评论进行倾向性分析,得出正面倾向的评论达到了平均72.44%,而负面及中性评论则只有13.90%和13.66%。

(2)通过对这20本书评论分析结果可以看到,评论数从几十到几千不等,但是其评论倾向还是趋同的。仅有4本书的评论中的正面评价低于70%,而其余16本都是在70%-80%之间;只有2本书的负面评价超过20%,4本书的负面评价低于10%,其余的都在10%-20%之间。

可以看出:大家对于图书的评论偏向于正面,可能有这样的原因:即在购买阅读完毕之后,如果觉得书好,会登录到网站进行评论,而如果觉得书不好,或者体验较差,再登录到网站写评论的热情将大为降低。

本文提出了一种基于词性的N-Gram模型用以抽取文本中的主观部分,设计了基于此的文本倾向性极性分类和强度计算方法,并通过程序进行了实现。通过已有的资源构建了文中使用的极性词典,并在实践过程中对其不断更新,该词典可以为今后文本倾向性分析的相关研究提供重要资源。当然,极性词典的更新,特别是领域极性词典的构建,并不是短时间内可以完成的,尤其在文本倾向性分析应用领域层出不穷、网络文本信息纷繁庞杂的环境下,需要认真地对待每一个领域内每一组有特殊意义的词语,慢慢积累。同时,前期开发的文本倾向性分析工具还需进一步完善,才能真正结合应用提高其通用性,更好地付诸实践。

| [1] |

|

| [2] |

|

| [3] |

|

| [4] |

|

| [5] |

|

| [6] |

|

| [7] |

|

| [8] |

|

| [9] |

|

| [10] |

|

| [11] |

|

| [12] |

|

| [13] |

|

| [14] |

|

| [15] |

|

| [16] |

|

| [17] |

|

| [18] |

|

| [19] |

|

| [20] |

|

| [21] |

|

| [22] |

|

| [23] |

|

| [24] |

|

| [25] |

|

| [26] |

|

| [27] |

|

| [28] |

|

| [29] |

|

| [30] |

|

| [31] |

|

| [32] |

|

| [33] |

|

| [34] |

|

| [35] |

|