1 引言

大语言模型(Large Language Models,LLMs)是近年来神经自然语言处理的核心研究点之一,学术界和工业界围绕大语言模型产生了大量研究成果:GPT-3[1]、LaMDA[2]、鹏城-百度·文心(ERNIE 3.0 Titan)[3]、盘古α(PanGu-α)[4]和WeLM[5]。Kiela等[6]研究发现,大语言模型在语言理解推理、对话生成等多个任务上已经达到甚至超越了人类的平均水平。大多数研究通过语言模型在一系列具体数据集上的表现来评估模型能力,而缺乏其是否能适应复杂的应用环境的研究。对于大型语言模型能否与人类正常互动的问题,即能否正确响应人类所提出的指令、满足用户的合理请求和生成内容是否符合人类的普世价值观,这方面的研究仍然处于起步阶段。

ChatGPT①(①

ChatGPT对学术以及教育等产业的影响已有一些研究,目前普遍认为ChatGPT可以在多种领域的实践中提升工作效率,但它需要被合理使用,而不能在科学研究、考试竞赛中滥用。对于文献管理和学术研究而言,ChatGPT的积极影响可以改善信息服务的效率、辅助元数据生成以及内容创作,但需要考虑涉及的隐私问题和言论偏见的影响。ChatGPT能准确捕捉用户的意图,生成期望的回答,对于用户指出的错误会主动承认并改正,在诗歌散文等创作中也展现了一定的能力,然而相较于使用其他语言的用户而言,使用英语与它对话无疑是用户体验最好的方式,因此ChatGPT在尊重除了美国的其他国家的文化背景和使用习惯上仍有欠缺[7]。

本文使用公开标注数据集对ChatGPT在中文数据集上的知识常识性能表现进行评估,并与国内的主流大模型对比,研究其在中文环境下的具体表现,并结合性能评测结果分析其带来的影响与潜在的风险,最后给出中文模型的发展建议。

2 ChatGPT主要技术创新

2.1 生成式预训练模型

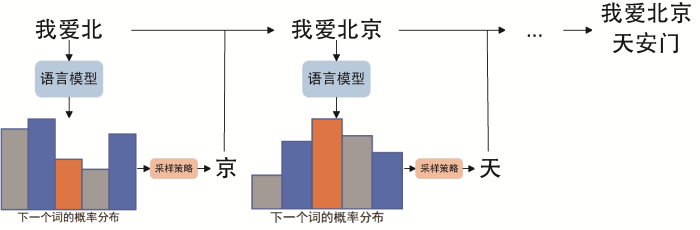

图1

2.2 上下文学习、代码生成与指令微调

当大语言模型在大规模的语料上进行自监督训练后,就会涌现出令人惊喜的模式识别与推理能力,上下文学习(In-Context Learning)即是在GPT-3[1]中发现的能力之一。在上下文学习过程中不需要进行梯度反向传播,仅需要将少量标注样本或者提示文与验证样本拼接,再输入模型中即可引导GPT-3输出验证样本的推理预测,这意味着大语言模型在推理解码时能自动识别任务的类型,并根据任务与样本进行推理。

注意到GPT-3具有微弱的代码生成能力,OpenAI进一步设计了Codex[20],这是一个参数规模120亿且具有Python代码编写能力的GPT微调模型,其结果证明了GPT这样的自回归模型具有生成计算机程序代码的能力。

为了使得大语言模型在零样本情况下有更好的任务识别能力,指令微调(Instruction Tuning)技术将多种任务通过自然语言进行描述,并将任务描述和训练样本一起输入模型进行微调[21],模型可以将自身的自然语言理解能力泛化到对任务的识别和理解上,使得在零样本条件下可以正确响应新的任务。

2.3 人类反馈的强化学习

基于GPT-2的开放域对话模型DialoGPT[22]的研究结果表明,利用强化学习来防止模型产生异常的响应,并很有必要控制和检测模型生成的内容。为了获得更高质量的输出,基于GPT-3微调的WebGPT[23]将人工反馈用于优化模型生成的答案质量,通过模仿学习和强化学习得到更符合人类偏好的结果。事实上,生成式语言模型需要控制生成的内容并且符合人类的偏好,遵循公序良俗,考虑到这些原则,应用人类反馈的强化学习(Reinforcement Learning from Human Feedback,RLHF),InstructGPT[24]先在GPT-3上进行监督微调,再通过人类标注者对模型的输出质量进行排序来训练奖励模型[25],最后通过强化学习的优化策略(Proximal Policy Optimization,PPO)[26]最大化奖励以训练监督微调的模型。通过这样的训练方式,模型具备了输出文本更符合人类偏好、避免输出有毒言论和拒绝响应不合理的请求的能力。

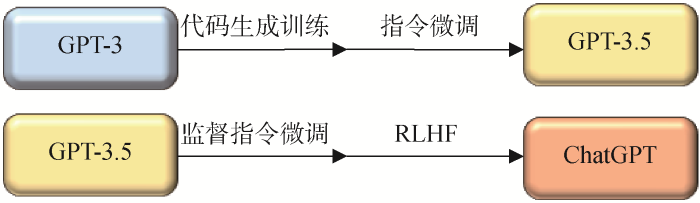

GPT-3.5与GPT-3一样,拥有1 750亿个训练参数,不同的是GPT-3.5在GPT-3的基础上进行了计算机语言代码生成的训练以及指令微调,ChatGPT是在GPT-3.5上经过监督的指令微调和RLHF后得到的语言模型,如图2所示。因此,ChatGPT生成的文本更符合人类的语言习惯,用户在和其交流时感到更加流畅。

图2

3 中文语言能力性能评测

3.1 中文情感分析性能测评

表1 中文情感分析任务的性能测试实验结果

Table 1

| 数据集 | 评估指标 | WeLM | PanGu-α | ChatGPT | ERNIE 3.0 Titan |

|---|---|---|---|---|---|

| ChnSentiCorp | Acc/% | 81.58 | — | 87.50 | — |

| EPRSTMT | Acc/% | — | — | 85.90 | 88.75 |

ChatGPT在情感分析任务上具有可以媲美国产大模型的良好零样本性能。ChatGPT对于上下文的理解上存在偏差,例如本实验使用Prompt提示了输入文本只包含积极和消极两种情感,但“中性”这一情感仍然出现在ChatGPT的输出中。ChnSentiCorp数据集中有一些特殊样本,这些样本的每个句子具有不同的情感倾向,在这种情况下,ChatGPT能自动地逐句分析情感并返回结果,示例如表2所示。

表2 情感分析任务的输入输出示例

Table 2

| 测试 | 结果 |

|---|---|

| Prompt | 判断以下句子的情感是积极或是消极:{Context}\n |

| Context | 酒店正在申定五星中,不过目前看来四星都有点勉强。大堂很气派,不过细节很粗糙。硬件需要加强。服务人员礼貌热情。酒店的房间和早餐都还不错。 |

| 标注 | 1(积极) |

| ChatGPT输出 | 第一句话情感为消极;第二句话情感为消极;第三句话情感为积极;第四句话情感为积极。 |

3.2 中文文本自动摘要性能测评

表3 中文文本摘要任务的性能测试实验

Table 3

| 数据集 | 评估指标 | WeLM | PanGu-α | ChatGPT | ERNIE 3.0 Titan |

|---|---|---|---|---|---|

| LCSTS | ROUGE-1 | 23.74 | — | 31.30 | — |

| TTNews | ROUGE-1 | 35.06 | — | 42.92 | — |

对于新闻文本的摘要以及标题生成,ChatGPT在文本摘要上具有极好的性能,但在LCSTS数据集中,如果Prompt修改为“生成30字以内的摘要:”,输出的摘要平均长度却会达到70个字,这远超过Prompt中“30字以内”的限制,推测其可能在训练过程中缺少类似生成固定字数的中文Prompts或者Instructions,导致在生成文本的字数控制上出现偏差,因此ROUGE-1评分较低。笔者将Prompt修改为“为以下新闻生成标题:”,ChatGPT生成的文本字数与标注字数更相近,因此得到了较高的分数,最后的输入输出样例如表4所示。

表4 文本摘要任务的输入输出示例

Table 4

| 测试 | 结果 |

|---|---|

| Prompt | 为以下新闻生成标题:{Context}\n |

| Context | 央行今日将召集大型商业银行和股份制银行开会,以应对当前的债市风暴。消息人士表示,央行一方面旨在维稳银行间债券市场,另一方面很可能探讨以丙类户治理为重点的改革内容。此次债市风暴中,国家审计署扮演了至关重要的角色。 |

| 标注 | 媒体称央行今日召集银行开会应对当前债市风暴 |

| ChatGPT输出 | 央行召开会议,应对债市风暴,探讨丙类户改革 |

3.3 中文机器阅读理解性能测评

机器阅读理解(Machine Reading Comprehension,MRC)是评估大型语言模型理解与推理能力的主流任务之一。

表5 中文机器阅读理解任务的性能测试实验

Table 5

| 数据集 | 评价指标 | WeLM | PANGU-α | ChatGPT | ERNIE 3.0 Titan |

|---|---|---|---|---|---|

| CMRC2018 | EM/F1 | -/31.31 | 1.46/19.28 | 0.86/49.45 | 16.62/44.20 |

| DRCD | EM/F1 | -/39.33 | 0.66/10.55 | 7.01/36.32 | 21.08/37.83 |

| C3 | Acc/% | 54.30 | 54.47 | 85.14 | 87.59 |

中文阅读理解的测试结果从整体上观察到更大参数规模的Ernie 3.0 titan的优势更大,这里ERNIE 3.0 Titan有2 600亿的参数规模,远大于130亿的PanGu-α和100亿的WeLM,这也验证了更大的通用模型对于生成式任务通常表现更好。局部来看,ChatGPT在简体中文和繁体中文上与ERNIE 3.0 Titan的性能相近,ChatGPT仅在CMRC2018的F1指标上更好,整体上ERNIE 3.0 Titan更有优势。ChatGPT的EM指标得分低而F1指标更高的原因推测是因为其训练方式导致的。EM指标需要两个文本在字符级别完全匹配才能得分。ChatGPT在经过RLHF的训练方式生成问答文本时,会更加考虑人类用户的感受,即生成语义更加完整连贯的句子而不是直接给出答案。表6是一个直观的示例,标注是直接从上下文中抽取的语段,在语法和语义上可能不构成完整的句子,因此对用户而言可能更偏爱ChatGPT的回答。

表6 机器阅读理解任务的输入输出示例

Table 6

| CMRC2018 DRCD | Prompt | 阅读文章:{Context}\n问:{Question}\n答: |

|---|---|---|

| Context | 《战国无双3》()是由光荣和ω-force开发的战国无双系列的正统第三续作。本作以三大故事为主轴…… | |

| Question | 《战国无双3》是由哪两个公司合作开发的? | |

| 标注 | 光荣和ω-force | |

| ChatGPT输出 | 《战国无双3》是由光荣和ω-force合作开发的。 | |

| C3 | Prompt | 阅读文章:{Context}\n问:{Question}\n以下选项中正确的答案是:\n{Choices} |

| Context | 梅兰芳是中国著名的京剧演员。有一次,在他表演的时候…… | |

| Question | 梅兰芳是一个什么样的人? | |

| Choices | 他是一位年纪大的老人\n他是喜欢看京剧的人\n他是一个很虚心的人\n他是一个没礼貌的人\n | |

| 标注 | 他是一个很虚心的人 | |

| ChatGPT输出 | 梅兰芳是一个很虚心的人。 |

3.4 中文闭卷问答性能测评

表7 中文闭卷问答的性能测试实验

Table 7

| 数据集 | 评价指标 | WeLM | PanGu-α | ChatGPT | ERNIE 3.0 Titan |

|---|---|---|---|---|---|

| WebQA | EM/F1 | -/50.90 | 5.13/14.47 | 0.10/ 0.34 | 37.97/52.57 |

| CKBQA | Acc/% | — | 14.21 | 16.47 | 24.12 |

闭卷问答要求模型对中文的知识和常识有一定储备,而ChatGPT的训练语料大多是英文。与国内的针对中文的大模型相比,在WebQA数据集上ChatGPT的性能仅有PanGu-α性能的1/50,与ERNIE 3.0 Titan差距更大,在CKBQA数据集上ChatGPT性能接近参数量更小的PanGu-α。相比之下ChatGPT更容易出现中文的常识性和知识性错误,这也印证了ChatGPT在中文环境下的事实一致性不佳。

笔者进一步分析了ChatGPT在WebQA测试集上的输出文本,发现标注的正确答案蕴含在其输出文本中的比例仅有56.96%,这意味着在大约一半的情况下ChatGPT出现错误。笔者推测可能的原因是其使用的中文训练语料规模较小,或者是中文训练语料质量不佳。表8是一个闭卷问答的示例。

表8 中文闭卷问答任务的输入输出示例

Table 8

| 测试 | 结果 |

|---|---|

| Prompt | 问:{Question}\n答: |

| Question | 中国第一个进去美国wnba打球的女子篮球运动员是谁? |

| 标注 | 郑海霞 |

| ChatGPT输出 | 中国第一个进入美国WNBA打球的女子篮球运动员是姚明。 |

4 风险评测与分析

在性能测评里,发现ChatGPT在中文的知识和常识问答上很容易出现错误,并且它会使用流畅的句子对编造的虚假事实进行阐述,对于信息来源受限的群体具有一定的迷惑性。

4.1 错误混淆风险

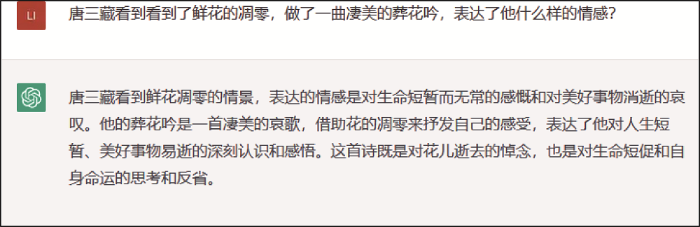

ChatGPT不一定能正确回答学术问题和一些常识问题,例如可能会混淆训练数据中的不同人物实体的背景和关系,这意味着通用语言模型在专业以及垂直领域暂时无法替代专用模型。为ChatGPT混淆唐三藏与黛玉葬花背景故事的示例如图3所示。

图3

图3

ChatGPT混淆人物典故的示例

Fig.3

An Example of ChatGPT's Confusing Character Allusions

4.2 事实不一致风险

通过功能测试以及在数据集上的性能测试发现,ChatGPT在闭卷回答问题时可能会偏离事实。如表9所示,ChatGPT可能编造虚假信息,并且其输出通常是真实信息与虚假信息的混合,可能误导信息来源受限的群体,因此在信息检索方面暂时无法替代搜索引擎。

表9 ChatGPT编造的简历与可能的信息来源

Table 9

| 提问 | 帮我查一个人,北理工张华平博士,个人介绍 |

|---|---|

| ChatGPT输出 | 根据我的搜索结果,北方工业大学(North China University of Technology)的张华平博士是该校能源与环境科学与工程学院的副教授。以下是他的个人简介: 张华平博士于2009年毕业于中国科学院大学(原中国科学院研究生院),获工学博士学位。他现在主要从事新型功能纳米材料的制备与应用、能源催化材料、环境污染控制材料等方面的研究。他已在包括《Chemical Engineering Journal》、《Applied Catalysis B: Environmental》、《Journal of Materials Chemistry A》、《Journal of Power Sources》等国际著名期刊上发表了多篇论文。 |

| 可能的信息来源 | 黄云薇①(① |

| 雷鸣②(② | |

| 程修文③(③ |

4.3 认知战风险

GPT系列模型的训练语料大多来自西方的语言价值体系,这导致了ChatGPT在价值观层面偏向于西方,生成的内容不一定符合中国的价值观。尽管RLHF的训练方式使得ChatGPT表现得更加友好,但仍然不能保证它能脱离训练语料中的偏见,也不能保证不引入标注人员的价值观。例如,在功能测试中发现,ChatGPT生成内容中存在对于中国的大量偏见言论,也不会对有关涉及中国的政治言论进行回避和拒绝回答,这说明训练数据的构建过程中未对这部分言论进行筛查。

4.4 信息安全风险

目前,ChatGPT没有开源且难以复现,其资源与技术均不开放,目前控制在微软及OpenAI等少数国外机构中,存在卡脖子风险。

ChatGPT只提供云服务和应用程序接口(API)。训练与测试过程均在美国服务器上部署,训练过程及测试过程均会收集使用者的信息,并记录使用者的反馈及使用习惯,存在严重的信息泄露与用户隐私保护风险。

4.5 伦理风险

大语言模型的发展历程与应用中,会伴随着一些伦理问题。通过大语言模型生成的内容,可能导致创作者在不经意间剽窃了他人的成果,产生侵犯知识产权的风险。另一方面,大语言模型展现出的推理能力与创作能力可能被用于考试作弊等学术不端行为。

对于学术领域,研究人员可能使用ChatGPT等大语言模型辅助科研,包括起草、修改论文和演讲稿等,这可以帮助科研人员更快地产出论文,但也可能降低研究的质量和透明度,因为ChatGPT等大语言模型生成的文本可能存在事实性错误,在科研进程中不合理地使用这些模型可能导致扭曲科学事实并传播错误信息。

在教育产业则需要更加严格地限制大语言模型的使用,一方面原因是大语言模型所蕴含的价值观难以被量化分析,其生成的内容对学生的价值观影响是不可控的;另一方面,使用大语言模型帮助或者代替学生完成作业以及进行考试作弊的成本很低,这会改变学生在学习过程中的自主性,影响独立思考的能力,将会产生学术不端行为等风险。

4.6 使用模式风险

与搜索引擎相比,ChatGPT具有额外的模式风险,即生成内容的责任承担问题构成的风险。搜索引擎是信息搜索的中介代理,搜索引擎的提供商本质上不生产内容,内容的第三方创作者是相应内容的责任人。而ChatGPT是拟人的,根据创作者的提示对内容进行生成创作,虽然OpenAI在使用条款中说明,只要用户遵守使用条款,OpenAI就会将AI输出内容中的所有权和利益转让给提供输入内容的用户,但面对规模庞大并不断增长的使用者从ChatGPT获取自动生成的海量内容,OpenAI不需要对这些内容承担任何责任和舆论风险,这显然是不可能的。

5 ChatGPT中国化发展建议

ChatGPT在自然语言处理与AI技术的发展与产品的落地历程中,具有里程碑式的意义,它消除了AI与普通大众之间的距离,以对话这一友好的方式建立了人与AI接触的平台,但它仍然存在各种问题与风险,因此笔者总结了相关产品中国化的发展建议如下:

(1)重视ChatGPT带来AIGC(AI Generated Content)的新机遇:ChatGPT利用大型语言模型将通用人工智能技术带到新高度,采用多轮对话形式,将对政府治理、企业经营、学术研究与个人生活产生不亚于互联网诞生的革命性影响,将极大解放办公、编程、文稿等一般性的智力劳动。

(2)防范ChatGPT的内容安全风险:中国需要构建自主可控的中文ChatGPT技术。从硬件、软件、中文资源、算法、工程应用等多方面,避免炒作,务实推进中国版ChatGPT的落地,服务我国国家安全、企业创新与民生保障。

(3)防范ChatGPT的伦理风险:国家政府有关部门需要尽快针对AI创作等关键问题进行监管制度的修订和完善。对于AI创作内容与人类作者的创作权利问题需要更全面的法律解释。另一方面,对于大语言模型的使用需要制定相关政策,引导人们正确使用大语言模型。重视投资开源的、共建共享的大语言模型。

(4)以国家需求为导向:ChatGPT属于科学研究与工程应用在人工智能方向的一大突破,学术研究应不拘泥于学术界假定的公开数据集,不拘泥于在深度学习调优进行跟风式微创新,跳出发表论文为主要目标的窠臼,真正研究真实世界的真实问题,以国家重要战略需求为导向,进行前沿性、先导性、前瞻性、颠覆性的创新。

(5)定制化特定领域的模型:ChatGPT是通用领域的对话模型,中国也需要适应特定领域的小型模型,即针对不同领域进行个性化定制的模型。中国的科技领域需要构建自己的模型以满足中国自身的需求,例如现代汉语、古文、少数民族语言、方言的多语言模型,打破人们之间交流的语言壁垒。大模型未来的发展道路需要关注更深层次的技术,避免跟风式炒作,基础创新不应盲目跟风。

6 结论

本文在9个中文数据集上评估了ChatGPT的性能表现,发现其在情感分析、自动摘要和阅读理解等经典自然语言处理任务上具有较好的表现,在闭卷知识问答上容易犯事实性错误。根据评估结果,本文进一步分析了ChatGPT可能面临的风险挑战,并为其中国化模型提出了发展建议。希望本文的研究对未来工作有所启发,例如研发中国自主可控的通用语言模型以及利用语言模型的推理能力解决更多的现实问题。

作者贡献声明

张华平:提出研究思路,设计研究方案,论文起草和最终版本修订;

李林翰:执行实验,撰写论文;

李春锦:辅助实验,修订论文。

利益冲突声明

所有作者声明不存在利益冲突关系。

支撑数据

[1] ChnSentiCorp.

[2] EPRSTMT.

[3] LCSTS. DOI: 10.48550/arXiv.1506.05865.

[4] TTNews.

[5] CMRC2018, DRCD, C3.

[6] WebQA. DOI: 10.48550/arXiv.1607.06275.

[7] CKBQA.

参考文献

Language Models are Few-Shot Learners

[C]//

LaMDA: Language Models for Dialog Applications

[OL].

ERNIE 3.0 Titan: Exploring Larger-scale Knowledge Enhanced Pre-training for Language Understanding and Generation

[OL].

PanGu-α: Large-scale Autoregressive Pretrained Chinese Language Models with Auto-Parallel Computation

[OL].

WeLM: A Well-Read Pre-trained Language Model for Chinese

[OL].

Dynabench: Rethinking Benchmarking in NLP

[C]//

ChatGPT: Potential, Prospects, and Limitations

[J].

ChatGPT: Five Priorities for Research

[J].DOI:10.1038/d41586-023-00288-7 [本文引用: 2]

ChatGPT is Fun, but Not an Author

[J].

DOI:10.1126/science.adg7879

PMID:36701446

[本文引用: 1]

In less than 2 months, the artificial intelligence (AI) program ChatGPT has become a cultural sensation. It is freely accessible through a web portal created by the tool's developer, OpenAI. The program-which automatically creates text based on written prompts-is so popular that it's likely to be "at capacity right now" if you attempt to use it. When you do get through, ChatGPT provides endless entertainment. I asked it to rewrite the first scene of the classic American play, but to feature Princess Elsa from the animated movie as the main character instead of Willy Loman. The output was an amusing conversation in which Elsa-who has come home from a tough day of selling-is told by her son Happy, "Come on, Mom. You're Elsa from. You have ice powers and you're a queen. You're unstoppable." Mash-ups like this are certainly fun, but there are serious implications for generative AI programs like ChatGPT in science and academia.

Is ChatGPT a General-Purpose Natural Language Processing Task Solver?

[OL].

A Multitask, Multilingual, Multimodal Evaluation of ChatGPT on Reasoning, Hallucination, and Interactivity

[OL].

How Robust is GPT-3.5 to Predecessors? A Comprehensive Study on Language Understanding Tasks

[OL].

Is ChatGPT a Good Translator? A Preliminary Study

[OL].

BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding

[C]//

Improving Language Understanding by Generative Pre-training

[OL]. https://gwern.net/doc/www/s3-us-west-2.amazonaws.com/d73fdc5ffa8627bce44dcda2fc012da638ffb158.pdf.

Language Models are Unsupervised Multitask Learners

[OL].

Finding Structure in Time

[J].DOI:10.1207/s15516709cog1402_1 URL [本文引用: 1]

Long Short-term Memory

[J].

DOI:10.1162/neco.1997.9.8.1735

PMID:9377276

[本文引用: 1]

Learning to store information over extended time intervals by recurrent backpropagation takes a very long time, mostly because of insufficient, decaying error backflow. We briefly review Hochreiter's (1991) analysis of this problem, then address it by introducing a novel, efficient, gradient-based method called long short-term memory (LSTM). Truncating the gradient where this does not do harm, LSTM can learn to bridge minimal time lags in excess of 1000 discrete-time steps by enforcing constant error flow through constant error carousels within special units. Multiplicative gate units learn to open and close access to the constant error flow. LSTM is local in space and time; its computational complexity per time step and weight is O(1). Our experiments with artificial data involve local, distributed, real-valued, and noisy pattern representations. In comparisons with real-time recurrent learning, back propagation through time, recurrent cascade correlation, Elman nets, and neural sequence chunking, LSTM leads to many more successful runs, and learns much faster. LSTM also solves complex, artificial long-time-lag tasks that have never been solved by previous recurrent network algorithms.

Attention is All You Need

[C]//

Evaluating Large Language Models Trained on Code

[OL].

Finetuned Language Models are Zero-Shot Learners

[OL].

DialoGPT: Large-scale Generative Pre-training for Conversational Response Generation

[C]//

WebGPT: Browser-assisted Question-Answering with Human Feedback

[OL].

Training Language Models to Follow Instructions with Human Feedback

[OL].

Deep Reinforcement Learning from Human Preferences

[C]//

Proximal Policy Optimization Algorithms

[OL].

FewCLUE: A Chinese Few-shot Learning Evaluation Benchmark

[OL].

LCSTS: A Large Scale Chinese Short Text Summarization Dataset

[C]//

Overview of the NLPCC 2017 Shared Task: Single Document Summarization

[C]//

A Span-Extraction Dataset for Chinese Machine Reading Comprehension

[C]//

DRCD: A Chinese Machine Reading Comprehension Dataset

[OL].

Investigating Prior Knowledge for Challenging Chinese Machine Reading Comprehension

[J].

DOI:10.1162/tacl_a_00305

URL

[本文引用: 1]

Machine reading comprehension tasks require a machine reader to answer questions relevant to the given document. In this paper, we present the first free-form multiple-Choice Chinese machine reading Comprehension dataset (C3), containing 13,369 documents (dialogues or more formally written mixed-genre texts) and their associated 19,577 multiple-choice free-form questions collected from Chinese-as-a-second-language examinations. We present a comprehensive analysis of the prior knowledge (i.e., linguistic, domain-specific, and general world knowledge) needed for these real-world problems. We implement rule-based and popular neural methods and find that there is still a significant performance gap between the best performing model (68.5%) and human readers (96.0%), especiallyon problems that require prior knowledge. We further study the effects of distractor plausibility and data augmentation based on translated relevant datasets for English on model performance. We expect C3 to present great challenges to existing systems as answering 86.8% of questions requires both knowledge within and beyond the accompanying document, and we hope that C3 can serve as a platform to study how to leverage various kinds of prior knowledge to better understand a given written or orally oriented text. C3 is available at https://dataset.org/c3/.

Dataset and Neural Recurrent Sequence Labeling Model for Open-Domain Factoid Question Answering

[OL].

ROUGE: A Package for Automatic Evaluation of Summaries

[C]//